从美股到A股,今日全球存储概念股集体暴涨。美股闪迪大涨27%,西部数据涨超16%,美光涨10%,A股恒坤新材20CM涨停,安集科技、长川科技、普冉股份、聚辰股份大幅走强。

在这背后,黄仁勋在CES发布的演讲和新品,再次推高了本就火热的存储行情。

他表示,存储“目前仍是一个完全未被开发的市场”。AI驱动的存储需求已经超过了现有基础设施的容量。“我们现在处理的上下文内存、token内存和KV缓存的数量都太大了,旧的存储系统根本无法满足需求。”

“AI正在重塑整个计算栈——而现在,也包括存储。AI不再是一次性问答的聊天机器人,而是能够理解物理世界、进行长周期推理、保持事实一致性、调用工具完成真实工作的智能协作者,并具备短期与长期记忆能力。”

之后他宣布英伟达将推出由BlueField-4 驱动新一代AI原生储存基础架构,重构面向下一阶段AI的存储架构,并用“革命性”一词来形容这一项创新。

新存储平台是什么?

英伟达的存储新平台全称为NVIDIA Inference Context Memory Storage Platform(英伟达推理情境内存存储平台)。

据官方介绍,该平台通过扩展GPU可用内存容量,为上下文记忆提供基础设施支持,实现跨节点的高速共享。

从架构上来说,这个平台实际上是为了AI推理专门打造了一层高速、低能耗的“上下文记忆”存储层,将原本只能放在昂贵且有限的GPU HBM的KV cache(KV缓存)扩展到NVMe 闪存和跨机群共享。

与传统存储方案相比,其可将每秒可处理的token数提升最高5倍,并实现最高5倍的能效优化。

有何突出?

本次英伟达的新平台是首次将AI推理KV缓存当成独立基础设施层来设计。

在此之前,一般KV缓存有三个路径选择:GPU的HBM(快,但贵且容量极小)、 CPU内存(稍慢且规模有限)、SSD/存储(便宜但延迟不可控)。

黄仁勋在CES的演讲中,用“革命性的”来形容这一项创新。

他指出,这本质上是在机架内直接加入一个极快的KV缓存上下文存储系统。整个行业之所以如此兴奋,是因为对于当今所有进行大规模Token生成的机构企业而言,KV缓存都是一个痛点。“所以,我们要创建一个新平台、一个新处理器来运行整个Dynamo KV缓存上下文内存管理系统,并将其放置在离机架其余部分非常近的地方,这个想法是完全革命性的。”

AI推理瓶颈转向上下文存储

在新平台的介绍中,“KV缓存”一词频繁出现,一定程度上来说,这也是促使英伟达开发新平台的关键原因之一。

黄仁勋在最新的CES演讲中强调,AI推理瓶颈正从计算转向上下文存储。随着模型规模提升以及用户使用量的提升,AI处理需要多轮对话、多步推理的复杂任务时会产生大量上下文数据。而传统网络存储对短期上下文而言效率过低,AI存储架构需要重构。

这种海量的上下文数据通常以KV缓存的形式存在,对推理准确性、用户体验以及交互连续性——即备受追捧的“个性化AI”能力至关重要。

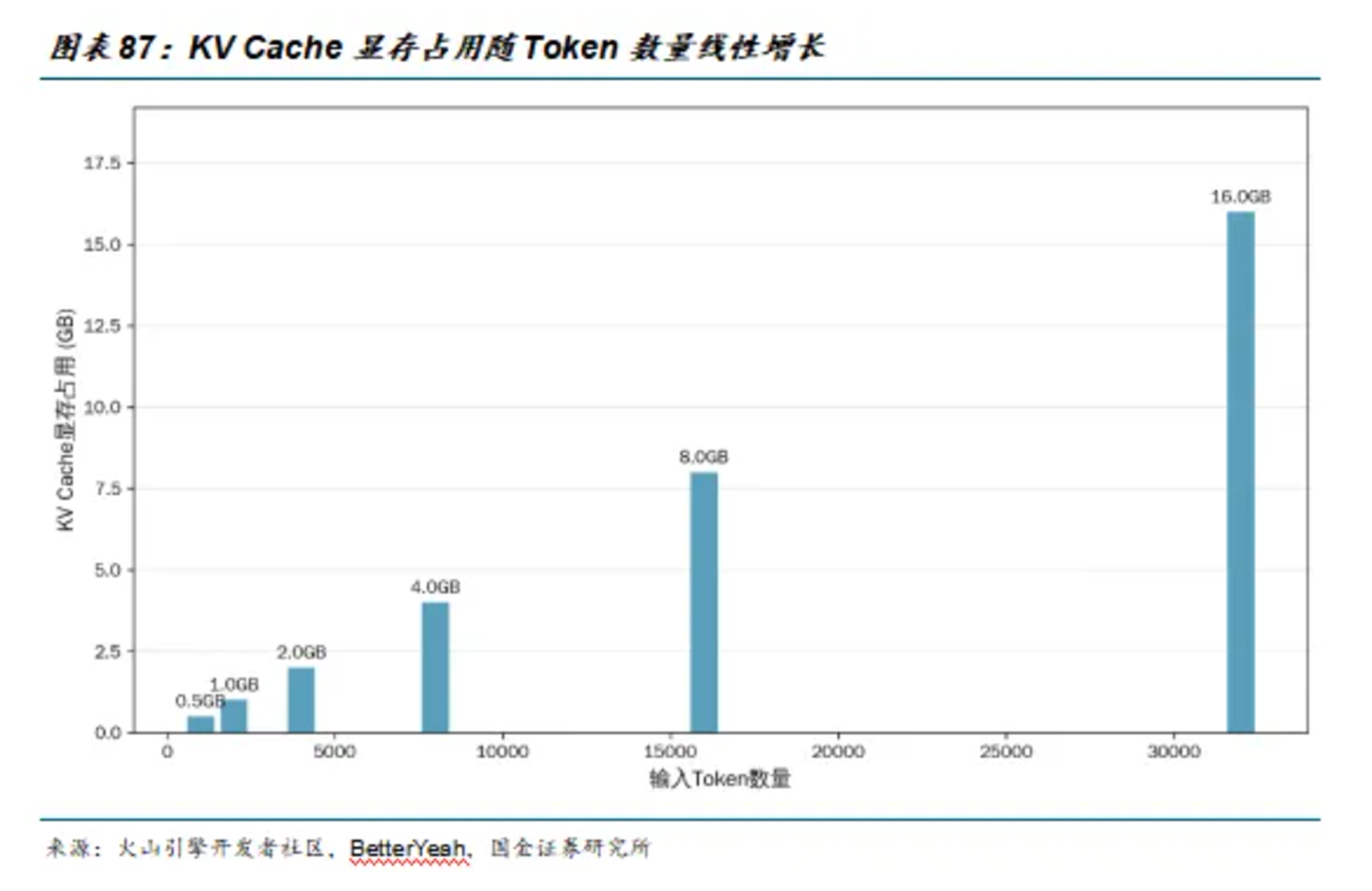

“推理时代”下,KV缓存显存占用随Token数量线性增长,同时KV Cache的优化效果也与文本长度正相关。