茨克维的言论直指当前AI行业的核心矛盾:依赖“ Scaling Law”(缩放定律)——即通过堆砌算力、扩大模型参数和数据量来提升性能的发展模式——可能正触及天花板。 他主张行业重心需要从“规模竞赛”回归到“研究突破”。

为什么“规模化”路径可能难以为继?

1.高质量数据即将耗尽:

互联网上公开可用的高质量文本、图像数据已被大型模型基本消耗殆尽。未来的数据获取成本将急剧上升,甚至可能引发版权和数据隐私的激烈冲突。

“数据质量”比“数据量”更重要。单纯堆砌低质数据不仅效果递减,还可能让模型性能“中毒”。

2.算力边际效益递减:

模型性能的提升速度已开始低于算力投入的增长速度。训练一个比当前最强模型再提升10%的模型,其成本可能是几何级数的增长,从经济上看已不划算。

如他所说,各大科技巨头已囤积了海量算力,但如何更高效地利用这些算力,而非一味追求更多算力,成为新课题。

3.技术瓶颈凸显:

当前的Transformer架构可能潜力已近挖掘殆尽。在现有架构下,单纯的放大无法解决模型的本质缺陷,如“幻觉”问题、逻辑推理能力不足、能源消耗巨大等。

如果回归“研究阶段”,重点会在哪里?

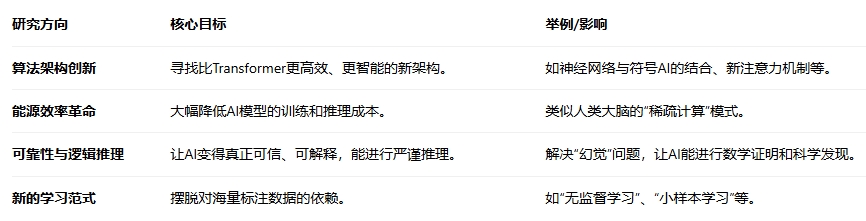

苏茨克维所指的“回归研究”并非否定大模型的价值,而是呼吁一场新的范式革命,重点可能集中在:

对行业和投资的潜在影响

对巨头公司:竞争焦点可能从“算力军备竞赛”转向“基础研究突破能力”。拥有顶尖基础研究实验室的公司(如OpenAI、DeepMind)的长期价值会更加凸显。

对初创企业:机会不再局限于训练千亿级大模型。在垂直应用、模型优化、数据清洗、新型算法等细分领域会出现大量机会。单纯靠“我们有个更大模型”的创业故事将难以获得投资。

对芯片和云计算公司:短期需求依然强劲,但中长期看,如果算法实现革命性突破,对算力增长的需求模式可能会改变。市场将更关注能效比,而不仅仅是绝对算力。

对投资界:投资者需要更专业的眼光来辨别什么是真正的“技术突破”,而非仅仅被参数量和算力消耗所吸引。投资周期可能拉长,需要更多耐心支持底层研究。

总结

苏茨克维的论断可视为对当前AI行业过热投资和同质化竞争的一次“清醒剂”。如果他的预言成真,意味着AI领域将进入一个深水区:

短期:基于现有大模型的商业化应用仍是主流和热点。

中长期:行业的下一波爆发式增长,必须等待一次类似于“Transformer”级别的基础性、架构性的研究突破。在那之前,行业可能会经历一个从“狂热”到“冷静”再到“扎实创新”的调整期。

这实际上为AI的健康和可持续发展指明了方向,即从“大力出奇迹”的工程化时代,迈向一个更需要原始创新的科学驱动时代。

#工信部:深入实施“机器人+”应用行动##OpenAI联手博通!AI产业链怎么投?##今年你的投资目标达成了吗?#$平安先进制造主题股票发起C(OTCFUND|019458)$$天弘中证人工智能C(OTCFUND|011840)$