液冷作为AI算力基础设施的重要组成部分,与光模块、PCB类似,深度绑定全球AI算力建设浪潮,但相较于已大幅上涨的光模块和PCB,液冷仍处于早期发展阶段,近期逐步引发了市场关注。

今天,我们来聊聊这个小众行业。

什么是液冷

液冷技术是指使用液体(如水或其他冷却液)代替空气作为冷媒,与发热部件进行热交换,从而带走热量的技术。与传统的风冷系统相比,液冷能够更有效地降低设备温度,提高设备性能和寿命。

想象一下你的手机或电脑在玩游戏时发烫,就像一个人在做高强度运动,身体发热。

传统风冷 = 吹电风扇

以前,我们给服务器降温就是用大功率风扇对着吹(风冷)。这就像夏天很热的时候,你吹电风扇。风吹过皮肤表面,带走热量。

问题:当运动强度极大,身体像个火炉(比如AI芯片功耗高达1000瓦)时,电风扇的风根本不管用,会中暑(过热降频甚至烧坏)。

液冷 = 泡冷水澡 或 贴退烧贴

既然吹风没用,我们就换一种效率更高的方式:直接泡到冷水里,或者用湿毛巾、退烧贴紧紧贴在皮肤上。水的导热能力是空气的25倍,降温效果立竿见影。

这就是液冷:我们把发热的芯片直接和“退烧贴”(冷板式液冷)紧密接触,或者干脆把整个服务器“泡澡”(浸没式液冷),让液体直接把热量带走。

冷板式液冷(贴退烧贴)是目前的主流。在发热最厉害的CPU和GPU芯片上,贴上一块内部有水流管道的金属板(冷板)。冷却液在冷板内部流动,直接带走芯片热量。服务器里其他不太热的部件,还是用风扇辅助散热。

优点:对现有服务器改造相对容易,技术比较成熟。

浸没式液冷(泡澡)是更彻底的方式。直接把整个服务器主板完全浸没在一种不导电的特殊液体(氟化液)里。芯片产生的热量直接传递给液体,被循环冷却的液体带走。

优点:散热效率极高,几乎没有噪音,能大幅降耗。但成本更高,对液体和密封性要求也高。

相比传统风冷,液冷技术具备更高的散热效率、耗、低TCO、低噪声和低占地面积等显著优势,是现阶段及未来长期内电子设备解决散热压力、应对节能挑战的重要途径。

为什么AI时代液冷的重要性大幅提高?

电子设备发热的本质原因是工作能量损耗为热能。

芯片作为电子设备的核心部件,其基本工作原理是将电信号转化为各种功能信号,而这个过程会产生大量热量,这是因为电子信号的传输会伴随电阻、电容、电感等能量损耗,这些损耗会被转化为热能。

温度过高会影响电子设备工作性能,甚至导致电子设备损坏。对于稳定持续工作的电子芯片,最高温度不能超过85℃,温度过高会导致芯片损坏。

(数据来源:《电子芯片散热技术的研究现状及发展前景》)

1. AI推动功耗快速提升,逼近风冷散热极限

根据Vertiv数据,风冷芯片解热上限为TDP<1000W。而随着芯片功耗密度持续提升,GPU功耗不断提升,未来依旧有持续提升的趋势。芯片性能持续发展,这提升了芯片功耗,也对散热技术提出了更高的要求。

例如:

英伟达最早在2022年5月推出液冷GPU——A100 80GB PCIe液冷GPU,2023年5月,Supermicro推出业内首个NVIDIA HGX H100,提供高达80kW的直接芯片(D2C)冷却。

这一时期,全球采用英伟达H100 AI GPU在散热解决方案上呈现选择多样化趋势,但风冷仍然是主流选择。

Blackwell性能激增,液冷方案成为必须。英伟达发布Blackwell时宣称,芯片在液冷服务器情况下测得的FP4精度算力能达到20petaflops。尽管英伟达并不强制要求使用液冷,但若想充分利用Blackwell芯片,液冷几乎成为必选项。英伟达、鸿海、广达等均在英伟达GTC 2024大会展出了自己的GB200液冷服务器和液冷机柜。

英伟达计划2027年推出的Rubin Ultra NVL576(600kW等级)Kyber机架,将彻底摒弃风冷,实现100%液冷。

2.政策严控PUE,更高效的散热方案是关键

PUE(总功耗/IT设备功耗)是表征数据中心能耗的核心指标。

PUE,就是衡量一个数据中心(IDC)“过日子”是否节俭的指标。它看的是总电费里,有多少是真正用在“干活”上的。

IT设备功耗就是用在服务器上的电,而总功耗就是除了整个数据中心用的电,还包括了空调、照明甚至电梯等等,但是核心是降温用的电费。

PUE = 2.0:这意味着你每花2块钱电费,只有1块钱是给服务器“干活”的,另外1块钱被空调、照明等辅助设施“浪费”掉了。这个餐厅非常浪费,不会过日子。

PUE = 1.5:现在好多了,每花1块5毛钱,有1块钱用于干活,只有5毛钱被辅助设施消耗。这是很多传统数据中心的水平。

PUE = 1.2:这非常优秀!每花1块2毛钱,就有1块钱用于干活,辅助设施只花了2毛钱。这是一个非常“节俭”、高效的数据中心。

所以,PUE的值越接近1,就说明这个数据中心的能源利用效率越高,越省电、越环保、运营成本越低。

最新国家要求:到2025年底,平均PUE降至1.5以下,新建及改扩建大型和超大型数据中心PUE降至1.25以内,国家枢纽节点数据中心项目PUE不得高于1.2。

从当前实际情况来看,实地运行的数据中心PUE较政策要求仍有较大差距,温控系统是降低PUE的关键。传统风冷方案的数据中心PUE一般在1.5左右,风冷的PUE极限在1.3左右,冷板式液冷最做到1.1,浸没式液冷能接近1.0。

PUE就像数据中心的“节能成绩单”,分数越接近100分(PUE=1)越好。它直接关系到数据中心的成本和环保性能,而液冷技术是拿到高分的关键法宝。

因此,随着AI算力的持续提升和政策要求,液冷在当前可能迎来快速爆发的时点。

液冷产业链包含哪些环节?

由于浸没式液冷对用户习惯改变较大,冷却液价格高昂,且存在环保和毒性争议,浸没式液冷更像是一项“未来技术”。目前冷板式液冷是当前以及短期内的主流方案。

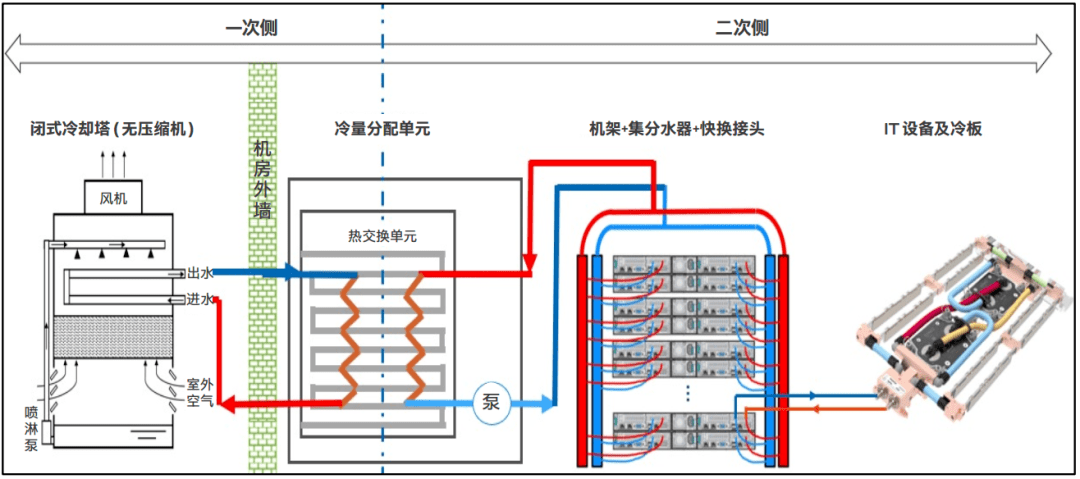

冷板式液冷的核心原理是 “间接冷却” :冷却液并不直接接触电子元件,而是在一个封闭的循环系统中,通过金属冷板与芯片接触带走热量。冷板式液冷系统架构整个过程通常分为两个循环侧:

1. 一次侧循环(室外循环/主循环)

作用:将整个数据中心的热量最终散发到大气中。

工作流程:冷却水在冷却塔或干冷器中被环境空气冷却→通过管道泵入室内的CDU(冷量分配单元)中的换热器→在换热器中吸收来自二次侧的热量后变热→再流回冷却塔降温,如此循环。

可以理解为一个空调的室外机和室内机。

2. 二次侧循环(室内循环/次循环)

作用:直接冷却服务器芯片,并将热量传递给一次侧。

工作流程:来自CDU的低温冷却液 → 通过Manifold(分水器)分配 → 经UQD(快速接头)连接到服务器 → 流入紧贴芯片的液冷板,吸收芯片热量变为温水 → 温水汇集后流回CDU → 在CDU内部的换热器中将热量传递给一次侧的冷却水,自身被冷却 → 再次被泵出,循环工作。

关键点:一次侧和二次侧在CDU内部通过换热器进行热量交换,但物理上是完全隔离的两个回路。这样做的目的是保证服务器内部的冷却回路非常洁净,而室外侧的水路即使脏了、有杂质,也不会影响服务器。

风冷到液冷的变化主要发生在二次侧,因此液冷的核心组成构件包括冷量分配单元CDU、冷板、循环管路、快接头UQD和分水器Manifold等部件。

1. 液冷板 (Cold Plate)

功能:系统的“退烧贴”。这是一块内部有精密微通道的金属板(通常为铜或铝),直接紧贴在高功耗的CPU、GPU芯片上。冷却液流经微通道,直接带走芯片产生的热量。

特点:设计和加工工艺要求高,需要与芯片表面完美接触以确保导热效率。

2. 快速接头 (Quick Disconnect, QD)

功能:系统的“快充接口”。用于连接服务器内部的液冷板和机房侧的固定管路。允许服务器在不断电、不漏液的情况下进行热插拔(Hot Swap),方便维修和更换。

特点:要求极高的密封性和可靠性,是保证系统安全的关键。

3. manifold (分水器/集管)

功能:系统的“水龙头总管”。通常一个机柜配一个,安装在机柜顶部或底部。它一端连接CDU来的主干管道,另一端通过多个阀门和接口将冷却液分配到这个机柜里的每一台服务器。

特点:实现了对机柜内服务器的集中供液和回液管理。

4. CDU (冷量分配单元)

功能:系统的“心脏和大脑”。这是整个液冷系统的核心控制单元,通常一个机柜或几个机柜配一台。它内部集成有:

- 水泵:为二次侧循环提供动力。

- 换热器:进行一次侧和二次侧的热交换。

- 控制器:监控流量、温度、压力、漏液等参数,并智能调节泵速和阀门。

- 水箱:补偿和稳定系统压力。

特点:集动力、换热、控制、监控于一体,是技术含量最高的部件。

产业链竞争格局

目前液冷的不同构件国内均有上市公司布局:

- 液冷板:大逻辑为国产替代,先发极为重要

液冷板需要重资产投入(产线+测试设备),一般只有老牌散热大厂才有资金实力投入。为保证产品一致性,服务器厂商一般只选择2-3家冷板供应商,进入名录后没有大事故就会持续供应。

无论是国内还是海外,目前都仍以台厂为主,主要包括奇鋐(AVC)、双鸿(Auras)、Cooler Master;国内液冷板的玩家主要有英维克、飞荣达、中航光电、立讯精密等,目前国内大逻辑为国产替代。

- CDU:国内厂商率先兑现业绩环节

基础设施型产品,使用寿命多为10-20年,产品可靠性和服务兜底能力是客户选供应商的重要参考。

格局:目前还是多以机柜式CDU为主,存在本地安装及运维特征,因此国内项目基本均以国内厂商为主,国内玩家主要有英维克、比赫电气(非上市)、申菱环境、高澜股份、曙光数创等。海外以Vertiv为主(收购CoolTera),其他厂商还有CoolIT、Motivair等。

- 快速接头:海外以欧美厂商为主,也有一些国内厂商进入市场

全球维度下,快接头目前暂无类似冷却塔的CTI认证,在海外OCP认证认可度相对较高,但影响力有限,国内目前不太参考此认证。

跨品牌适配是目前快接头的核心问题,Intel倡议的UQD标准暂时统一了规格,但是在跨品牌适配上仍需时间推进。

格局:海外目前的供应商多为欧美厂商,包括美国的Parker、CPC、瑞士的Staubli、丹麦的Danfoss及瑞典的CEJN;国内使用较多的快接头品牌是中航光电和Staubli。

未来,液冷赛道或将诞生新的行业龙头,中国企业未来具备较强的增长潜力。

总结

AI驱动的未来图景已经展现,其背后是算力需求的爆炸式增长。作为算力核心的GPU/ASIC芯片,功耗已突破千瓦级,传统风冷如同“电风扇吹火炉”,早已触及散热天花板。同时,全球“双碳”目标下,各国政策对数据中心能耗指标(PUE)提出严苛要求,传统风冷数据中心PUE普遍在1.5以上,难以达标。

因此,AI芯片的“发热危机”与“节能政策”共同构成了液冷技术从“可选项”变为“必选项”的核心驱动力。它不仅是解决散热瓶颈的技术答案,更是推动数据中心走向绿色低碳、实现可持续发展的关键路径。

液冷产业的快速发展,可能刚刚拉开序幕。

$易方达上证科创50联接A(OTCFUND|011608)$

$易方达上证科创50联接C(OTCFUND|011609)$

$易方达中证人工智能主题ETF联接A(OTCFUND|012733)$

$易方达科创人工智能ETF联接C(OTCFUND|023565)$

$易方达上证科创板成长ETF联接发起式C(OTCFUND|019703)$

风险提示:基金有风险,投资须谨慎。本资料不构成本公司任何业务的宣传推介材料、投资建议或投资收益保证,也不作为任何法律文件。本基金管理人承诺以诚实信用、勤勉尽责的原则管理和运用基金资产,但不保证基金一定盈利,也不保证最低收益。基金管理人及基金经理过往获奖经历不预示本基金未来业绩表现。

本资料的观点分析及内容展示基于相关公开信息整理,不排除信息后续发生任何更新变化,不对该等信息的完整性、及时性作保证。未经易方达基金书面同意,禁止非合作方摘引截取或以其他方式转载或传播本资料。基金有风险,投资须谨慎。投资者不应以该等信息取代其独立判断或仅根据该等信息作出投资决策。投资者详阅基金法律文件,在全面了解基金产品的风险收益特征、运作特点及销售机构适当性意见的基础上,审慎作出投资决策。

#史上最薄iPhone来了 !果链影响几何?##A股缩量调整!沪指考验3800点关口##百辩基民秀之开诊吧##百辩基民秀之开诊吧##指数操盘手集结令#