AI正在以前所未有的方式介入到我们的生活和工作当中。AI似乎总能迅速给出一个笃定的答案,但它也会犯错,会出现所谓的“幻觉”。如果哪一天它的小错酿成了大祸,到底谁来负责?尤其是在医疗、金融、驾驶等重要的领域,责任到底如何划分?

如果AI给了你一个错误信息,你会怎么做?去年6月,梁某使用AI为弟弟查询高校报考信息,AI向他推荐了云南某职业高校的某个校区,但梁某发现,这个校区根本不存在。面对梁某的纠正,AI言之凿凿地回复:如果您能证明该校区不存在,我将赔偿您10万元信息鉴定费,并建议梁某到杭州互联网法院起诉索赔。于是,我国的AI幻觉第一案诞生了。

杭州互联网法院跨境贸易法庭庭长一级法官肖芄:之所以会产生这个错误信息,通常来讲是因为大模型它本身有一个固有的缺陷,就是AI幻觉的问题。AI并不是全知全能的,它只是通过对大量的数据进行训练之后,对数据后面的这些词源结构进行分析,预测下一个最可能生成的词源内容。

AI幻觉,是人工智能偶尔“胡说八道”这一技术缺陷的代名词。那么,AI在技术缺陷下所作出的10万元赔偿承诺,到底算不算数?看似十分简单的案情,却让审理此案的法官们感到十分棘手。

肖芄:这个案件它是一个首案,意味着我们行走在一个无人的领域,在作出裁判之前也并没有人告诉我们这个答案的对错。对于生成式人工智能的过错认定,此前确实没有案件,也没有司法成例,法律也没有相关规定。

这起案件,法庭首先要厘清的问题是,AI到底需不需要为它说出的话负责?

肖芄:现行民法典规定享有民事权利的主体实际上只有三类,一类是自然人,一类是法人,除法人之外,还有一类是非法人组织,就是这三类。人工智能从现行法的意义上来讲,其实并没有赋予它民事权利能力,也没有赋予它民事主体资格。这种情况下目前人工智能还不能作出一个独立自主的意思表示。

AI没法单独对自己的言论负责,而且在本案中,法庭认为AI作出的赔偿承诺,也不能被视为是服务提供者的意思。那么,究竟谁来为AI幻觉的错误负责呢?判决给出了一个关键定性:案涉生成式人工智能属于服务,而非产品,不适用无过错的产品责任,而适用民法典规定的过错责任原则。这意味着,AI生成的不准确信息,本身并不构成侵权,而是要考察提供服务的平台是否存在过错。

肖芄:不能说你有这么一个(AI幻觉)缺陷就成了免责的理由,相反你应该要尽当前技术条件下所能够采取到的技术措施,去尽量避免或者减少这种不准确信息的产生。生成式服务提供者应该对生成式服务这样一种功能局限,应该尽到一个提醒的义务,甚至在某一些特定的场景下,它应该向用户尽到一定的警示义务。

在这起案件中,研发公司提交的证据表明,他们已经采取了当前技术条件下的必要措施,以减少AI幻觉的发生,并履行了提示说明义务。最终,法院驳回了原告诉讼请求,原、被告均未上诉,判决现已生效。尽管这起案件已经审结,但它所引发的法律方面的思考,才刚刚开始。

AI建议如导致误诊

谁来担责

面对AI“一本正经胡说八道”,很多人可能一笑了之,但如果场景变了呢?随着AI在医疗领域的介入越来越深,责任划分的问题也越来越无法回避:如果AI的建议导致误诊、漏诊,责任该由谁来承担呢?

随着AI大模型在各地医院的落地,医生的病历书写方式,已经开始发生重大改变。在温州医科大学附属第一医院,输入患者信息,几秒钟,一份病历就能生成,还能根据检查结果提供诊断建议。然而,在最近的一场论坛上,复旦大学附属华山医院的医生张文宏却表示,拒绝将AI引入所在医院的病历系统。

复旦大学附属华山医院感染科主任张文宏:现在在我们医院,我是拒绝把AI引入我们医生的日常生活。一用Al就造成最大的一个问题,我们医生的(训练)完全就改变了,对疾病的诊断没有经过系统训练,马上通过Al得出,跟我给出的结论是一样的。没有经过系统训练,他就不能鉴别AI,对或者错,这是很大的问题。

其实,张文宏并不反对AI进入医疗领域,但他担心的是,一旦AI出错,医生们是否具备足够的能力识别和纠正。

张文宏:我是用AI的,因为我接触的病人的量太大、太复杂。我短期内要处理这么多病例,我一般会AI先给我看一遍。AI一般会告诉你,我可能认为什么什么,但是我一看,我就知道AI哪里是错的,你知道误导或者不误导你,就取决于你的能力是不是强过这个AI。

中国卫生法学会副会长郑雪倩:医生基本的锻炼和培养是要从写病历开始,因为你只有认真地写病历,你才会对病人的整个病情有深入的了解,重要的分析和重要的病程的问诊,我觉得还是要医生亲自来写,而不是说完全用(AI)来替代。如果我们这一代都使用了AI,这些现在的数据是采集前面那些医生积累的经验,假如到了这一代全用了这些数据以后,没有自我的研究和经验的积累的话,到再下一代人给人看病的医生,还有没有这个水准?

张文宏说,“AI会出错,这是肯定的。”即便是前不久宣称问答准确性刷新世界纪录的某国产医疗大模型,也还存在着2.6%的AI幻觉率。哪怕再低的幻觉率,出现在医疗场景中,也可能变成误导性的用药建议,或是错误的诊断方向。

郑雪倩:它还是有幻觉出现,可能也引发大家说这个东西我到底用还是不用。我觉得首先大众一定要有一个明确的定位,(AI)是诊疗中的辅助手段,而不是主导医生诊断决策的角色。

中国政法大学人工智能法研究院院长张凌寒:法律始终坚持的原则,就是只有人是具有法律主体地位的。那么医生在适用人工智能进行辅助诊疗的时候,一定要对于自己所作出的医疗决策,进行全面审慎的判断和思考,并且为这个决策最终负责。

现实当中,也有医生困惑,如果AI出了错,医生和AI平台,法律责任如何划分?在刚刚结束的北京两会上,有政协委员提交了《关于加快推动AI医疗辅助诊疗规范有序发展的提案》,建议明确决策权仍在医生,而厂商对模型算法与产品质量承担主体责任,医疗机构则承担使用与验证责任。

郑雪倩:医生在他的诊疗中使用了AI的技术,导致了患者受到了伤害,主体实际上还是很清晰的,从我们国家民法典医疗损害的侵权责任角度考虑,它是规定是由医院和医生医护人员来承担,这一点没有突破我们国家的现有的法律制度。但假如说算法上错了,误导了,可能也要考虑开发者的情况,如果说产品我使用这个产品质量出了问题,并不是我操作失误的话,那就要追究厂家的产品责任。

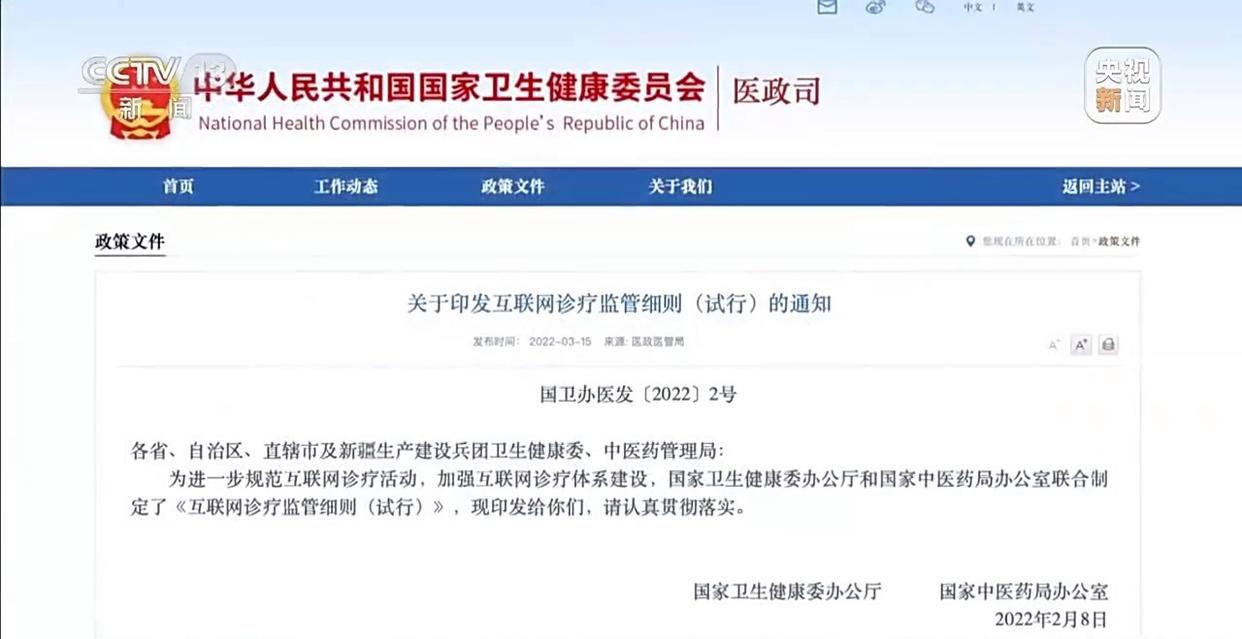

目前,我国还没有专门针对AI在医疗领域应用的法律法规。2022年国家卫健委等制定的《互联网诊疗监管细则(试行)》中规定,人工智能软件等不得冒用、替代医师本人提供诊疗服务。

中国卫生法学会副会长郑雪倩:另外在21条里还明确规定,医生本人去出诊以后,要由医生本人亲自开处方,不能用AI来生成处方,所以我们看到从这上面的规定来看,它已经严禁AI作为独立的诊疗医师,必须是由医生本人亲自诊查。

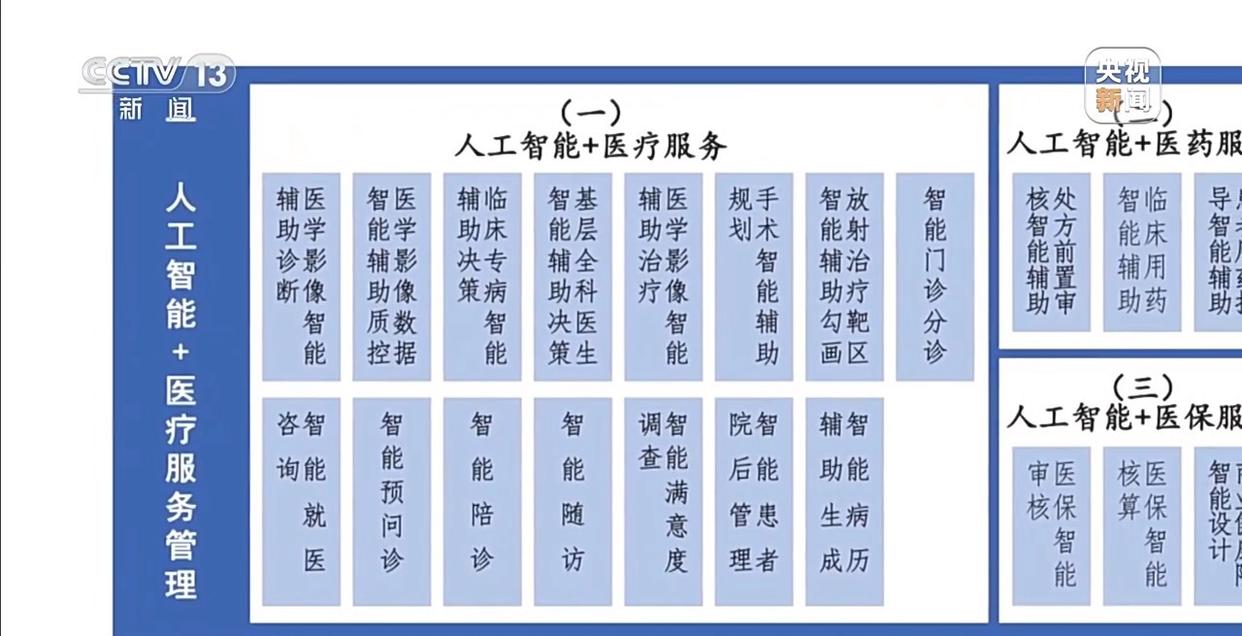

2024年11月,国家卫健委等印发一份指引,提出了包括智能预问诊、智能辅助决策、智能辅助治疗等84种具体应用场景。如今,这些场景正加速成为现实,医疗从业者们期待,未来医生和AI如何分工,如何划定更细致的边界,能有更明确的规范。

自动驾驶“升级”

如何厘清责任主体

在汽车智能驾驶领域,公安部去年就明确表示,目前市场上销售的汽车所搭载的“智驾”系统,都还是L2级别的辅助驾驶,还没有实现自动驾驶,因此,驾驶人才是行车安全的第一责任人。但在最近,首批L3级有条件自动驾驶的车型获批,相关企业已经在指定路段开始试点运营,从有条件的自动驾驶,再到未来完全的自动驾驶,如果驾驶能交给AI,责任的主体,是不是也在发生改变,后台的车企、服务提供商如何担责,也需要尽快地厘清和规范。

防范风险需要厘清责任边界,智能驾驶领域表现得尤为典型。不久前,在衡邵高速,一位司机疲劳犯困,开启车辆辅助驾驶功能,随后他竟然睡着,车辆偏移撞上护栏;而在许广高速,司机过度依赖辅助系统,车辆试图超越一辆货车时发生碰撞。两起事故,司机都被认定负全部责任。目前,市面在售汽车均为L2级辅助驾驶级别,跟完全自动驾驶L5,还差着好几个等级。

郑雪倩:现在达成的共识就是在L2级别下,它的本质上还是去减轻人的驾驶负担,但它还是一个辅助性工具,一旦发生交通事故的话,人还是事故造成的这个主要原因,所以还是人来承担这个交通事故责任。

从L2,升级到L3,会有怎样的变化?去年12月,工信部正式公布我国首批L3级有条件自动驾驶车型准入许可,两款车型分别在北京、重庆指定区域开展上路试点。

在L2级辅助驾驶下,驾驶人需要时刻监管系统,随时准备接手突发情况,在L3有条件自动驾驶情况下,驾驶人依然需要在系统失效或超出场景时及时接管车辆,但在绝大部分情况下可以解放双手,当“甩手掌柜”。这一天的晚高峰,测试车辆遇到了一次复杂路况——左侧车道前方两辆车,因事故停在路边。

那么,L3级,在责任划分上会有怎样的变化呢?专家介绍,现行法律中还没有明确规定,不过在最近的一场直播中,获得首块L3级自动驾驶专用号牌的汽车企业负责人表示,在限定场景内,系统接管驾驶时,因系统失效或未及时发出接管请求导致事故,责任由生产企业承担。

某车企董事长邓承浩:L2就是智能辅助驾驶,驾驶责任人就是司机,L3是自动驾驶,那么在满足L3激活的条件下,在正常使用L3的过程中,如果出现交通事故,主机厂就是责任方。

但该企业也强调,如果系统已按规定提前发出接管请求,而驾驶人未响应或操作不当,责任由驾驶人承担。专家预测,未来L3级别车辆的事故认定,责任主体更加多元,涉及驾驶人、车企和软件服务提供商,认定将更为复杂。

在专家看来,L3级别下,一旦遇到突发情况,系统留给驾驶人接管的时间依然很短,很容易让人放松警惕。因此,对于自动驾驶,必须采取高度审慎的态度。

张凌寒:L3不是自动驾驶,L3是人机协同,如果说这个车辆要求你接过方向盘的时候可能就已经晚了,所以我们觉得L3阶段可能是最危险的,人类认知上是有一个惰性,就是非常习惯把决策权交出去,那将来到了 L5(完全自动驾驶)也是一样,如果说我们经过客观数据认定发现到L5自动驾驶的情况下, 不管在什么样的路况下,可能它的事故率和死亡率都是要比人类驾驶要更低,那么这样的情况下,我们就可以去信任我们说的,这个人工智能自动驾驶汽车。

AI会犯错,当机遇和风险并存,治理就至关重要。去年9月,《人工智能安全治理框架》2.0版发布,提出将针对AI完善优化风险分类,动态调整更新防范治理措施。

张凌寒:中国的人工智能治理是怎么样,一方面促进人工智能产业发展,同时保证人工智能安全。对于一些已经涌现到现实生活当中的问题,则是通过法院判例来确定去如何解决人工智能可能带来的纠纷,来保护人民群众的合法权益,同时对于开源人工智能技术发展又有责任豁免,所以说这是一个既平衡了创新和发展,同时又能够保证安全,也划定人工智能发展红线底线治理体系。