2026开年未满一个月,DeepSeek就发布了两篇创始人梁文锋署名的论文——元旦抛出mHC架构论文破解模型稳定性难题,月中又靠Engram论文提出 “静态知识存为可检索记忆表”的新思路。

1月27日,DeepSeek开源模型DeepSeek-OCR 2(其核心定位为处理静态图像)并同步发布论文《DeepSeek-OCR 2: Visual Causal Flow(直译为“视觉因果流”)》。新京报贝壳财经记者浏览论文发现,视觉因果流机制可使模型不再像扫描仪一样按像素顺序“扫图”,而是能够像人类阅读一样,依据语义和逻辑关系理解图像内容,从而显著提升其在表格、文档和公式等复杂结构场景中的识别与理解效果。

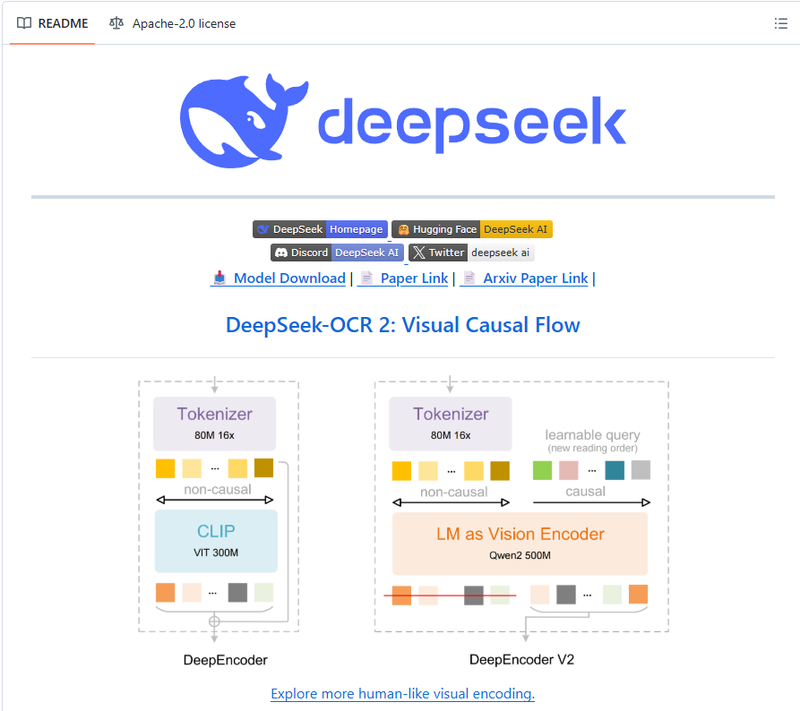

DeepSeek最新论文在github平台上的截图

不是模型不够强,而是看图的顺序不对

长期以来,主流视觉语言模型在处理图像时,普遍采用固定的像素扫描顺序。将图像切分为若干视觉单元后,按照从左到右、从上到下的方式输入模型。这种方式在自然图片中尚能发挥作用,但在表格、多栏文档、技术资料和数学公式等结构化内容中,却暴露出明显局限。

在这些场景下,信息之间往往存在清晰的语义层级和逻辑依赖,例如标题与正文、行名与数值、主公式与注释等。然而,固定的空间顺序无法反映这些关系,导致模型虽然能够识别局部文字,却难以还原整体结构,从而影响后续理解与推理效果。

随着模型规模不断扩大,这一问题并未得到根本解决。研究者逐渐意识到,性能瓶颈并不完全源于参数数量或算力不足,而在于视觉信息被组织和输入模型的方式本身。换言之,模型“看得见”,但“怎么看”才是关键。DeepSeek-OCR 2 正是在这一背景下提出,它尝试从根本上调整模型对图像的理解路径,而不是继续依赖更大的模型规模来弥补结构理解的不足。

先理清关系,再让模型去“理解”

在此背景下,DeepSeek-OCR 2的核心创新在于提出“视觉因果流”机制,使模型不再机械地按像素顺序处理图像,而是根据语义和逻辑关系动态组织视觉信息。在具体实现上,模型在视觉编码阶段引入语义与因果感知能力,通过改进的视觉编码器,对不同视觉单元之间的依赖关系进行建模,判断哪些信息在理解上具有先行性,哪些内容是对前者的补充或延展。

基于这种判断,模型会对视觉token进行动态重排,并结合可重组的位置编码,将结构更加清晰的序列输入语言模型。这样,语言模型在生成和推理阶段接收到的,不再是杂乱无序的像素序列,而是一条更接近人类阅读习惯的“理解路径”。研究团队将这一过程概括为“视觉因果流”,即图像中隐含的语义理解顺序。

实验结果表明,该机制在表格解析、多栏文档理解和公式识别等任务中表现突出,相较于前代 DeepSeek-OCR,整体性能提升 3.73%,阅读顺序(R-order)的编辑距离(ED)也显著降低(从0.085降至0.057),这表明新的DeepEncoder V2能够根据图像信息有效地选择和排列初始视觉标记。

论文最后表示,尽管光学字符识别,尤其是文档解析,是大模型时代最具实用价值的视觉任务之一,但它只是更广泛视觉理解版图中的一部分。未来,相关架构还将持续优化并拓展至更多复杂场景,进一步探索多模态智能在更深层次视觉理解中的潜力。