本周,人工智能初创公司月之暗面(Moonshot AI)的核心高管在“美版贴吧”Reddit上举行了一场AMA(可以问我任何问题)活动,回应了多项业界热点议题。

参与这项活动的三位高管分别为杨植麟(论坛用户名:ComfortableAsk4494)、周昕宇(zxytim)和吴育昕(ppwwyyxx),三人在24小时内持续回答了论坛上网友提出的问题。

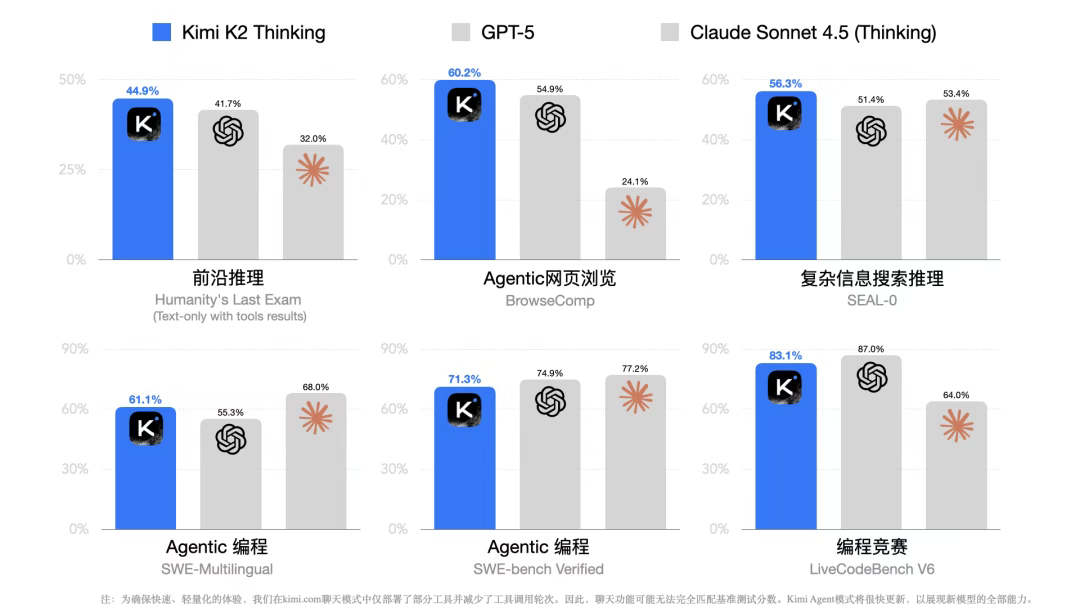

上周,月之暗面发布了Kimi K2 Thinking,公司称其为“迄今能力最强的开源思考模型”。因此,AMA活动上的大多数问题与K2 Thinking有关,有点像是该模型线上发布会的问答环节。

有人询问,为什么K2 Thinking能在单次推理中实现如此长的推理时间和推理链,而GPT5却做不到?GPT5 Pro通过智能体来延长推理时间,但推理效果仍然不如K2 Thinking单次长时间推理。未来是否会考虑进一步提升基础模型的推理速度?

杨植麟回答道:“我认为推理时间取决于API的吞吐量,而推理令牌的数量则取决于模型的训练方式。我们训练K2 Thinking的方式倾向于使用相对更多的推理令牌以获得最佳结果。我们的Turbo API应该会快得多。此外,K2原生支持INT4类型,这进一步加快了推理过程。”

当被问及“FP4相对于INT4的改进是否真的意义重大?”时,周昕宇称,选择INT4是为了更好地兼容“非Blackwell GPU”,同时利用现有的INT4推理marlin内核。

吴育昕在另一个问题下称,“我们使用配备Infiniband的H800 GPU;它不如美国的高端GPU那么好,而且我们的显卡数量也处于劣势,但我们充分利用了每一张显卡!”

有网友称,K2 Thinking似乎使用了过多的代币。杨植麟承认了这一现象,并解释道“当前版本中,我们优先考虑的是绝对性能而非代币效率。我们会尝试将效率纳入奖励机制,以便它能学习如何简化思考过程。”

有人质疑,K2 Thinking通过专门训练,以达到在高水平逻辑推理(HLE)测试中取得好成绩,但“它的高分似乎与实际使用中的智能水平不太相符。”

杨植麟回应称,“我们在提升智能体推理能力方面取得了一些进展,使其在HLE测试中得分较高。我们正在努力进一步提升其通用能力,以便在更多实际应用场景中充分发挥智能的作用。”

当网友询问“K2 Thinking培训费用只有460万美元是真的吗?”杨植麟回答道:“这并非官方数据,因为培训成本很难量化,其中很大一部分用于研究和实验。”

在点赞最多的回答中,周昕宇透露,公司的新架构KDA(Kernel Attention Dual Architecture)能让模型获得更高的基准测试分数,而且速度更快、效率更高,从而使我们能够更快地进行预训练、更快地部署到强化学习中,并服务更多用户。

周昕宇表示,“我们正在开发更多改进方案,完成后会与大家分享。”杨植麟也补充道:“KDA是我们最新的实验性架构,与KDA相关的想法很可能会在K3中得到应用。”

在被追问何时推出K3模型的问题中,杨植麟还调侃了OpenAI的首席执行官萨姆·奥尔特曼,他回应称,肯定能在“萨姆价值万亿美元的数据中心建成之前”推出K3模型。

有网友询问对“OpenAI为什么会烧掉这么多钱”的看法,周昕宇称“不知道。只有萨姆自己知道。我们有自己的方式和节奏。”周昕宇还提到,月之暗面没有人工智能浏览器的计划,因为“不需要去套一层新的Chromium壳”。

当被问及公司有没有“视觉-语言模型(VL)的计划时”,杨植麟写道:“是的,我们正在努力。敬请期待!”