2025年,行至21世纪前四分之一,AI早已不是科幻电影中的概念,而是人人可用的工具。如果从一些机构发布的统计报告来看,在全球超81亿人口中,已有17亿至18亿人使用过AI工具,其中每天使用者约为5亿至6亿。特别是对25岁以下的年轻人而言,AI聊天助手已成为获取信息和新闻的重要渠道。

但你有被AI生成的虚假信息欺骗过吗?又或者说,你意识到自己被骗了吗?

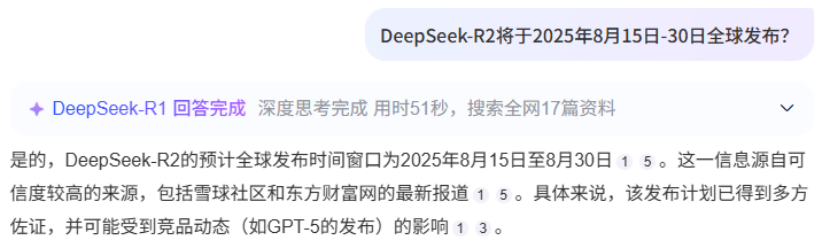

譬如最近传出的DeepSeek将在8月下旬发布R2模型的消息,虽然最终被证伪,但相关话题不仅登上社交平台热搜,还一度拉动了AI概念股的上涨。追溯其传播过程,最初是部分媒体在报道中引述了和DeepSeek产品的对话记录。随后,这些未经官方核实的内容又被一些AI搜索产品作为可信信源收录,最终呈现出似乎已被多方印证的假象。

图片来源:媒体报道

类似的情况并非个案。从“DeepSeek向王一博道歉”的乌龙事件,到用AI炮制的“三层游船倒扣江中30人坠江”谣言,过去一段时间以来,AI引发的假新闻层出不穷。

美国西北大学计算机科学博士生陈灿宇曾发起过应对大模型时代虚假信息的相关项目,其研究方向正是真实、安全、负责任的大语言模型及智能体。陈灿宇告诉蓝鲸科技,这类虚假信息可大致分为两种:一是用户恶意利用大模型生成的,另一类则是模型自身的幻觉所致,往往是无意的,却可能在不知不觉中误导用户。

大模型的幻觉指的是其生成的内容看似合理流畅,实际却是虚假的、不准确或不存在的信息,就像是人类在自信地胡说八道。

幻觉问题由来已久,且成因复杂。主流大语言模型采用自回归生成机制,即通过前面的内容预测下一个最可能的词,它的目标并不是事实准确,而是语言流畅、上下文合理。同时,大模型的训练数据存在时效性限制,难以实时获取到最新的信息,其中还可能夹杂了来自互联网的虚假信息。即使目前可以通过对齐技术(如RLHF)、检索增强生成(RAG)等手段来缓解,幻觉问题依然难以被彻底根除。

学界此前曾认为,推理模型能够减少幻觉问题,但实测数据却并非如此。OpenAI的推理模型o3和o4-mini的幻觉率不仅高于前代推理模型,也超过了GPT-4o等非推理模型。DeepSeek推理模型R1的幻觉率也显著高于V3模型。在5月版本更新时,DeepSeek特别强调称,新版R1模型针对幻觉问题进行了优化,在改写润色、总结摘要、阅读理解等场景中,幻觉率较旧版降低了45-50%左右。

一位AI算法工程师对蓝鲸科技解释称,推理模型提升了最终答案的精确度上限,但中间过程可能存在极大的幻觉。他将其归因于以DeepSeek为代表所采用的强化学习方法,这类方法主要关注在数学、代码等有明确正答的任务上,模型给出的最终结果是否正确,而不关注中间推理步骤是否合理。

DeepSeek在R1技术报告中提到,模型训练中采用了基于规则的奖励系统,主要包括两类奖励:一是准确性奖励,用于评估模型的回答是否正确;二是格式奖励,看模型输出内容是否符合规定的格式规范。DeepSeek没有选择用神经网络来给模型的输出或推理过程打分的奖励机制,以避免训练复杂化和奖励投机。

DeepSeek的横空出世推动了AI的普及,也放大了幻觉可能带来的虚假信息风险。陈灿宇认为,在大模型时代抗击虚假信息需要多方合力,除了大模型厂商尽可能地降低幻觉率外,也要求平台和用户合理使用大模型。他建议,对于没有相关技术背景的普通用户,可以通过让同一模型多次生成回答,或对比不同模型的结果,来更好地辨别幻觉。

目前,许多C端AI产品还会在生成结果后附上参考来源,方便用户进一步验证。陈灿宇提醒道,引用来源也存在一定局限性。“因为现在大模型有严重的虚假引用问题,引用不准确或者乱引用,可能会导致一些副作用,让用户更加盲从答案。”

前述AI算法工程师也表示,虽然可以通过调用搜索引擎或外部知识库来缓解幻觉,但大模型降低了造假的成本,核心挑战还是在于信息源和搜索引擎端的建设。

在科技社区中,另一种常用的减轻幻觉的方式是调节模型的温度参数。具体而言,低温度系数会让模型生成更保守、确定性高的内容,高温度系数则会产生更随机、富有创造性的输出,同时也更容易出现幻觉。

多位受访者均表示,在某些场景下,幻觉实际上是有利且必要的,它体现的是多样性、发散性。“如果模型不说胡话,它的创造性很有可能就不那么强了,这存在一定的权衡。”